Maha Karuna Ch’an, de zengroep onder leiding van Ton Lathouwers bestaat dit jaar 25 jaar. Vanuit de groep kwam het initiatief om iets doen met teisho’s (zen toespraken) die Ton in al deze jaren heeft gehouden. Ik heb in de 15 jaar dat ik bij Maha Karuna kom vele toespraken gehoord. Soms zijn ze heel ontroerend, bijna altijd inspirerend. Mij werd gevraagd of ik vanuit mijn kunstenaarschap een andere, meer beeldende benadering had om iets te doen met de teisho’s. Omdat nieuwe media mijn medium is leek het me interessant iets te doen met woordwolken die je op internet kunt genereren. Het idee hierbij is dat hoe vaker een woord in een tekst voorkomt, hoe groter het wordt afbeeld. Dit is dus een nieuwe manier om inhoud te visualiseren, die veel gebruikt wordt in blogs. Ik was benieuwd hoe de teisho’s zich hebben ontwikkeld, is er een rode lijn te ontdekken?

Verkenning

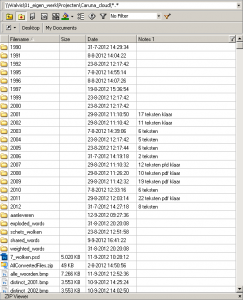

Stap één was het verzamelen van zoveel mogelijk teksten uit zoveel mogelijk jaren. Dit bleek niet eenvoudig. Het materiaal was fragmentarisch, van vroegere jaren bleek er nauwelijks iets gedigitaliseerd. Ik heb besloten om alleen te werken met jaren met voldoende tekstmateriaal. Dit zijn de jaren 2001, 2002, 2007, 2008, 2009 en 2011.

Mijn eerste idee was te werken met Wordl, een beroemde online tool, die fraaie wolken produceert. Deze tool bleek weinig inhoudelijke controle over het uiterlijk te kunnen uitoefenen, bovendien kon het niet zo’n lange teksten aan. Ik heb deze meer visuele tool aangevuld met de functionaliteit van Tagcrowd. Hiermee kun je woorden uitsluiten en woordaantallen weergeven die je als tekst kunt selecteren. Ik besefte dat ik zelf het een en ander moest programmeren om tot optimaal resultaat te komen.

Proces

Van verschillende mensen heb ik tekst bestanden gekregen. Deze moest ik ordenen, opschonen en onderzoeken wat echt bruikbaar was. Daarna heb ik de teksten van elk jaar samengevoegd tot één grote tekst en deze geupload naar Tagcrowd. Gaandeweg heb ik de lijst met uit te sluiten woorden uitgebreid en de verzamelde teksten diverse malen naar Tagcrowd gestuurd.

Zo’n analyse geeft al snel meer dan 500 verschillende woorden terug. Ik heb gekozen de meest voorkomende 150 woorden per jaar te gebruiken. Van ieder woord wist ik dan ook meteen hoe vaak het in dat jaar was genoemd. De resultaten kopieerde ik naar een tekstbestand. Dat zag er dan bijvoorbeeld zo uit: aarde (39) abe (117) allemaal (150) anderen (41), enz.

Het bleek dat Wordl een advanced setting had waarmee je in plaats van de lange tekst, direct een lijst met gewogen woorden kon invoeren in het formaat woord:aantal. Ik heb in Processing een programma geschreven om de Tagcrowd resultaten om te zetten naar het Wordl formaat:

af:44

allemaal:88

beeld:90

beelden:52

beetje:59

belangrijk:49

betekent:49

Deze gewogen woordlijsten heb ik geïmporteerd in Excel en gesorteerd op alfabet of meest voorkomend. Door de verschillende presentaties van woorden, kijk je op een andere manier naar de tekst, je ziet weer andere verbanden, andere woorden springen eruit.

Door zo te spelen met de woordlijsten en hun aantallen ontstonden de ideeën voor verschillende visualisaties. Ik vond de gewogen woorden in een wolk met mooie kleurtjes en lettertypen weinig betekenisvol. Gelukkig bood Wordl ook de mogelijkheid zelf middels een code (hexadecimaal) kleuren aan te geven, die heb ik uiteindelijk handmatig aan elk woord toegevoegd.

Visualisaties

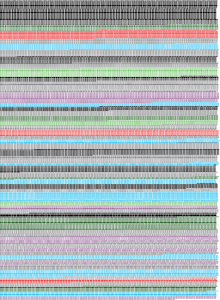

Vooral alle visualisaties waren de lijsten met gewogen worden de basis. Ik heb hierin verschillende hoofdthema’s onderscheiden: samen, mystiek, sutra, tijd, zen, taal en overigen. Elk thema eigen kleur.

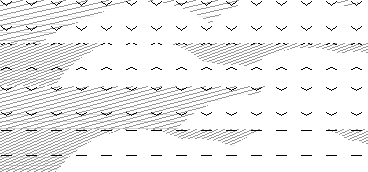

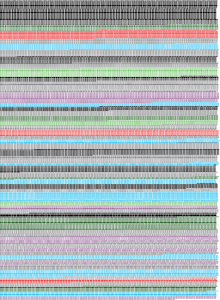

Pagina 1: van elk gekozen jaar de worden de 100 meest voorkomende woorden getoond. Ze zijn gesorteerd van meest naar minst voorkomend. Vormgeving en kleurtoekenning heb ik met de hand uitgevoerd in Illustrator.

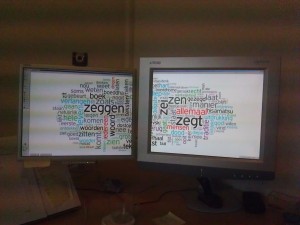

Pagina 2: Elk jaar heeft zijn eigen woordwolk, de centrale wolk bevat woorden die in alle jaren voorkomen. Ik heb een programma geschreven dat de zes lijsten met 150 meest voorkomende woorden doorloopt. Woorden die in alle lijsten voorkomen zijn bij elkaar gezet en het aantal vermeldingen van elk van die woorden is per woord bij elkaar opgeteld, deze bepalen de grootte van de woorden. Er waren in totaal 66 gemeenschappelijke woorden, variërend van 903 tot 252 vermeldingen. De kleurencodes heb ik handmatig aan de lijst toegevoegd:

allemaal:566:EF3B39

beetje:271:808285

boeddha:357:346734

boeddhisme:267:346734

boek:488:000000

diep:439:33C6F4

enz.

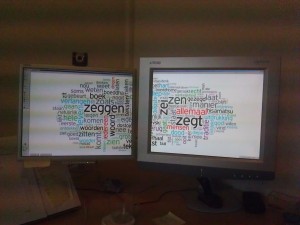

Hiermee heb ik een woordwolk gegenereerd in Wordl. Ik schreef ook een programma om de overige woorden per jaar uit te filteren en de aantallen bij elkaar op te tellen. Ook hier zijn kleurencodes handmatig toegevoegd en is voor ieder jaar afzonderlijk een wolk gegenereerd. (Zoals je ziet wordt Dostojevki lang niet zo vaak vermeld als Ton wel denkt.)

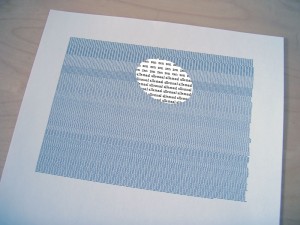

Pagina 3: Ik vond het ontroerend dat bepaald woord zo vaak is uitgesproken. Ik wilde recht doen aan die woorden en uitdrukken wat die hoeveelheden eigenlijk betekenen. Ik schreef een programma dat de meest voorkomende, gezamenlijke woorden zo vaak afdrukt als zij uitgesproken zijn. De kleuren zijn handmatig aangebracht in Illustrator.

Pagina 4: Deze wolk toont de verzameling van de 150 meest voorkomende worden van alle jaren. Het programma dat ik schreef kijkt per woord hoe vaak het woord voorkomt per jaar. In het totaal bleken er 300 verschillende woorden te zijn. De kleurcodes zijn gekopieerd uit de woordenlijsten met kleurcode die eerder handmatig waren aangevuld. Het leverde een gigantische woordwolk op die ik over mijn twee schermen heb verdeelt om zo de kleinere woorden ook te kunnen vangen. Het kleinste woord, jan kwam 15 keer voor.

Voor mij was het heel interessant om te ontdekken dat de woorden die ik zo goed ken uit de toespraken van Ton mysterieuzer schenen door ze op verschillende manieren bij elkaar te zien. Ik heb ze teruggeven aan zichzelf.

Ik wil Maha Karuna Ch’an hartelijk bedanken voor het gebruik van de teksten. Verder dank ik: Karin van der Molen, Mieke Coenen, Maria Werkhoven en Jo Ampe voor het aanleveren van de teksten.